[이뉴스코리아 손은경 기자] 인공지능(AI) 기술을 이용해 여성의 가짜 누드 사진을 생성하는 딥페이크 애플리케이션이 공개 몇 시간 만에 비공개로 전환됐다.

27일(현지시간) 미국의 IT전문매체 더버지는 가짜 누드 사진을 제조하는 개발사가 당사의 ‘딥누드(DeepNude)’ 어플리케이션 서비스 제공을 중단했다고 보도했다.

개발 연구진은 트위터를 통해 “딥누드를 향한 관심이 이렇게 뜨거울 줄 몰랐다”며 “사람들이 당사의 어플을 악용할 확률이 매우 높다”고 서비스 중단 사유를 밝혔다.

딥누드 어플은 당분간 판매되지 않으며 추가 버전 역시 출시되지 않는다. 어플을 실행하면 “세상은 아직 딥누드를 받아들일 준비가 되지 않았다”라는 종료 알림 메시지가 뜬다.

개발사 측은 딥누드의 딥페이크 기술을 악용하는 사례를 우려하며 온라인에서 딥누드의 소프트웨어를 공유하지 말라고 경고한 상태이다.

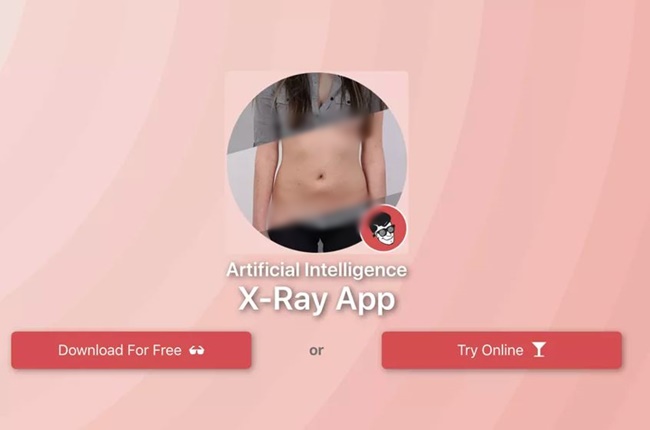

지난 26일(현지시간) 대중에 처음으로 공개된 딥누드 어플은 옷을 착용한 여성의 사진을 업로드한 뒤 해당 사진을 클릭하면 여성이 착용하고 있던 옷은 사라지고 나체의 모습이 드러나는 식으로 실행된다. 이 어플은 여성 버전으로만 출시됐으며 남성 버전은 출시 예정이었다.

개발사는 딥누드가 생성한 이미지가 가짜라는 것을 부각하기 위해 사진 저장 시 이미지에 ‘FAKE(가짜)’라는 워터마크가 삽입되게끔 설계했다. 무료 버전은 삽입되는 워터마크의 크기가 사진의 대부분을 차지할 정도로 크고, 이에 반해 50달러(약 5만7700원)짜리 유료 버전은 사진 하단에 작은 크기로 삽입된다.

그럼에도 많은 사람들이 개중 악질의 이용자가 가짜 이미지라는 상징의 워터마크를 제거한 뒤 누드 사진을 인터넷에 함부로 유포할 가능성이 높다고 지적했다.

알베르토 개발자는 더버지에 “내가 먼저 이 어플을 개발하지 않았더라도 누군가는 만들었을 것”이라며 “딥누드 어플이 안 좋은 경로로 악용되는 것을 확인하면 서비스를 아예 중단할 것”이라고 전했다.

저작권자 © 이뉴스코리아 무단전재 및 재배포 금지